0

据《纽约客》杂志报道,OpenAI的热门聊天机器人ChatGPT每天可能要消耗超过50万千瓦时的电力,以响应用户的约2亿个请求。相比之下,美国家庭平均每天使用约29千瓦时电力,也就是说,ChatGPT每天用电量是家庭用电量的1.7万多倍。

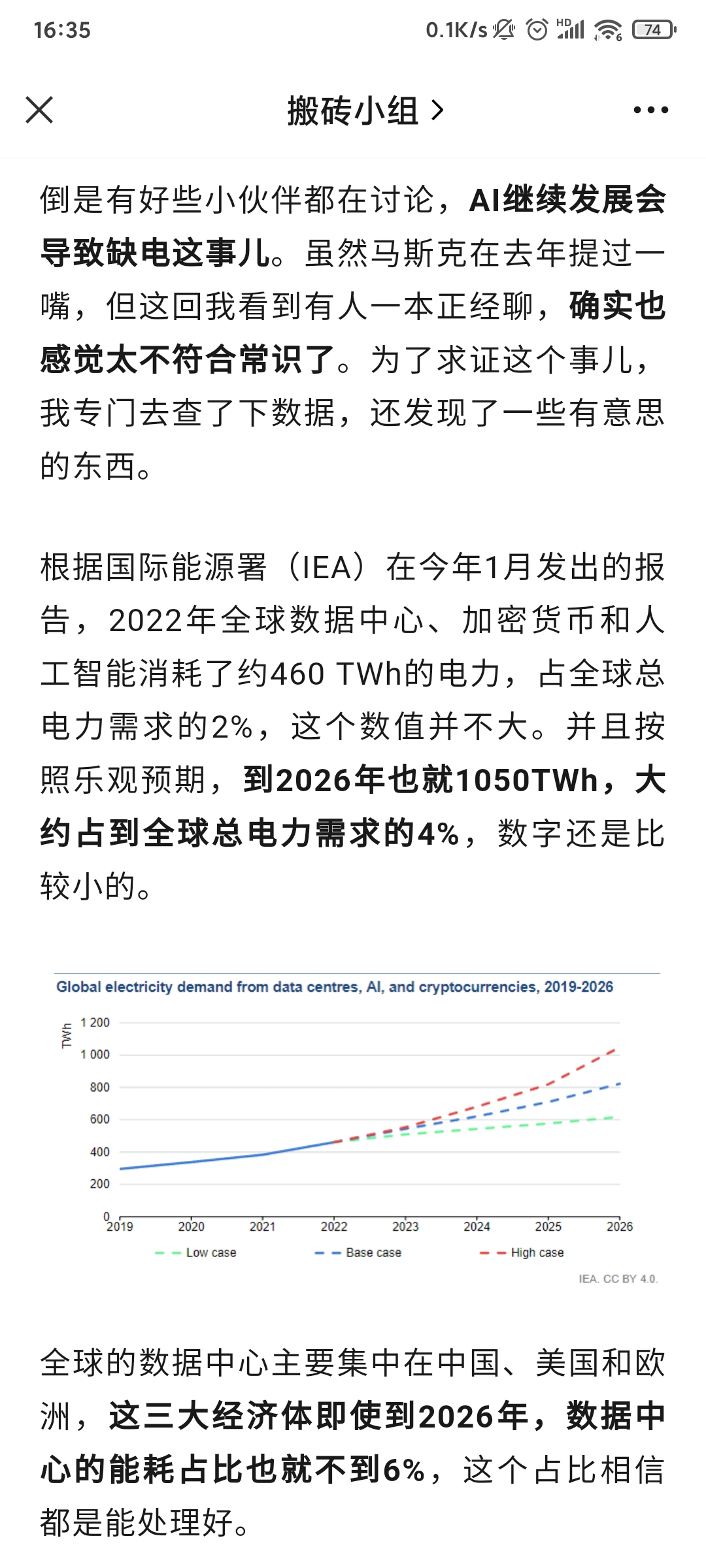

如果生成式AI被进一步采用,耗电量可能会更多。荷兰国家银行数据科学家亚历克斯.德弗里斯在一篇论文中估计,到2027年,整个人工智能行业每年将消耗85至134太瓦时(1太瓦时=10亿千瓦时)的电力。

随着人工智能技术发展,市场对芯片的需求激增,带动电力需求的激增。相关数据显示,十年前全球数据中心市场的耗电量为100亿瓦,而如今1000亿瓦的水平已十分常见。据美国Uptime Institute的预测,到2025年,人工智能业务在全球数据中心用电量中的占比将从2%猛增到10%。

生成式AI带来的种种创新,都是以处理性能和功耗方面的高昂成本为代价。马斯克曾预计,未来两年内将由“缺硅”变为“缺电”,而这可能阻碍人工智能的发展。在他看来,电力短缺可能会造成严重后果,就像最近缺芯阻碍科技和汽车行业一样。

如果生成式AI被进一步采用,耗电量可能会更多。荷兰国家银行数据科学家亚历克斯.德弗里斯在一篇论文中估计,到2027年,整个人工智能行业每年将消耗85至134太瓦时(1太瓦时=10亿千瓦时)的电力。

随着人工智能技术发展,市场对芯片的需求激增,带动电力需求的激增。相关数据显示,十年前全球数据中心市场的耗电量为100亿瓦,而如今1000亿瓦的水平已十分常见。据美国Uptime Institute的预测,到2025年,人工智能业务在全球数据中心用电量中的占比将从2%猛增到10%。

生成式AI带来的种种创新,都是以处理性能和功耗方面的高昂成本为代价。马斯克曾预计,未来两年内将由“缺硅”变为“缺电”,而这可能阻碍人工智能的发展。在他看来,电力短缺可能会造成严重后果,就像最近缺芯阻碍科技和汽车行业一样。

Edge

Edge Chrome

Chrome Firefox

Firefox

京公网安备 11010802031449号

京公网安备 11010802031449号